Компания Cognitive Technologies разработала технологию Cognitive Data Fusion, позволяющую максимально эффективно использовать в модели компьютерного зрения комбинированные данные, поступающие от различных сенсоров (видеокамер, радаров, лидаров и т.д.) непосредственно на вычислительный блок.

«В решениях многих зарубежных разработчиков систем автономного вождения обработка данных, как правило, ведется по принципу on-chip - непосредственно на чипах, которые установлены на различных сенсорах, что затрудняет комплексное использование и обработку информации, поступающей со всех датчиков», говорит руководитель департамента разработки беспилотных автомобилей Cognitive Technologies Юрий Минкин. «Это было бы равносильно тому, если зрение и слух у человека не были синхронизированы и не дополняли друг друга. Представьте, что машиной управляют одновременно слепой человек, который слышит и зрячий, но глухой. И еще при этом они между собой не коммуницируют», комментирует ситуацию Юрий Минкин.

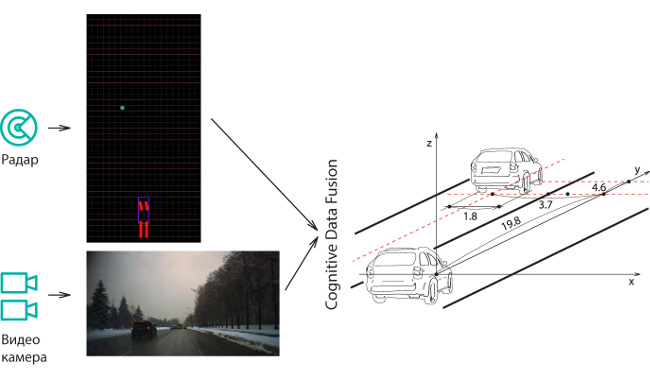

Преобразование данных о дорожной сцене, полученных с радара и с видеокамер по отдельности, в комплексное представление Cognitive Data Fusion

Как правило, данные полученные с радара позволяют определять точное расстояние до объекта и его скорость. Однако они дают лишь частичную информацию о его типе и расположении. Для принятия решения о том, является ли ситуация опасной, также важен тип объекта, его размеры и другие параметры. Так радар может достаточно точно распознать машину и засомневаться в узнавании пешехода. Также радар, по сути, не позволяет определять отдельные элементы дорожной сцены, такие как дорожные знаки, разметку и т.д. Информация, полученная с видеокамеры, в свою очередь, дает достаточно точные координаты объекта, представление о его типе, и взаимном расположении относительно других объектов. А также позволяет детектировать больший класс объектов дорожной сцены (сигналы светофора, типы знаков, дорожную разметку и т.д.).

Интеграция данных, полученных от различных устройств, позволяет восполнить недостающую для понимания текущей дорожной сцены информацию. Например, при уровне распознавания изображения объекта, полученного с видеокамеры, в 80%, данные, полученные от радара, могут дополнить недостающую информацию и поднять точность детекции до 99% и более процентов. Комплексное использование данных также позволяет объединить всю информацию о скорости, координатах, расстоянии до объекта, его типе, взаимном расположении, наличии других объектов в непосредственной близости от него и их физических характеристиках.

Задача глубокой интеграции данных, полученных от разных сенсоров довольно сложная. Принцип действия технологии Cognitive Data Fusion аналогичен тому, как функционирует мозг человека, получающий данные от различных органов чувств: зрения, слуха, тактильных органов и т.д. одновременно. Для этого информация, снятая с каждого из датчиков синхронизируется и приводится к единой системе координат. Затем, «сырые» данные поступают в вычислитель, где они комплексно обрабатываются взаимно «обогащая» друг друга. Такой подход позволяет также реализовать компенсаторную функцию - когда один из органов чувств человека отказывает или выполняет свои функции не в полном объеме, активность других существенно усиливается. Аналогичным образом в таких случаях архитектура Cognitive Data Fusion предусматривает возможность получения более детальных данных о дорожной сцене от других сенсоров. Например, если сигнал от радара детектирует препятствие на пути автомобиля, а видеокамера по каким - либо причинам его четко не распознает, искусственный интеллект оценит эту ситуацию, как проблемную и затребует более детальную информацию от видеокамеры. «Когда мы слышим громкий звук и не видим его источника, мы с двойным вниманием смотрим в направлении, откуда раздался звук, пытаясь понять его причину», говорит Юрий Минкин.

По словам Президента Cognitive Technologies Ольги Усковой: «Технология Cognitive data fusion уже апробирована на тысячах километрах российских дорог. Мы уверены, что ее внедрение позволит снизить уровень аварийности беспилотного автомобиля на 20%-25%».

Комментарии

(0) Добавить комментарий