Чтобы помогать человеку в его повседневной деятельности и успешно справляться с домашними делами, роботы должны уметь эффективно манипулировать предметами, которыми мы пользуемся каждый день. Однако некоторые объекты из-за их формы, гибкости и других особенностей трудно поддаются манипулированию роботами.

К таким объектам относятся текстильные салфетки, которые обычно используются человеком для очистки поверхностей, окон, зеркал и мытья полов. Все эти задачи потенциально могут быть выполнены роботами, но прежде чем это произойдет, роботы должны уметь эффективно захватывать ткани и манипулировать ими.

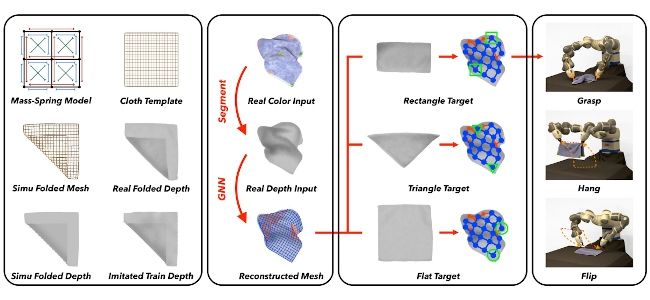

Исследователи из ETH Zurich представили новую вычислительную технику, позволяющую создавать визуальные представления смятых тканей, что, в свою очередь, может помочь в планировании эффективных стратегий захвата тканей роботами и их использования при выполнении задач. Эта методика, представленная в статье, предварительно опубликованной на сайте arXiv, оказалась хорошо обобщающей для тканей с различными физическими свойствами, а также различных форм, размеров и материалов.

"Точная реконструкция и манипулирование одной скомканной тканью представляет собой сложную задачу из-за высокой размерности модели ткани, а также ограниченности наблюдений в самозакрывающихся областях", - пишут в своей статье Вэньбо Ванг, Гэн Ли, Мигель Замора и Стелиан Корос. В своей работе они использовали модель, основанную на графовых нейронных сетях (GNN).

Для обучения своей модели исследователи собрали набор данных, содержащий более 120 000 синтетических изображений, полученных в результате моделирования, а также более 3000 помеченных изображений ткани, полученных в реальных условиях. После длительного обучения на этих двух наборах данных было обнаружено, что модель эффективно предсказывает положение и видимость вершин ткани, просто рассматривая ткань сверху.

Для оценки эффективности своей модели исследователи провели ряд тестов, как в симуляции, так и в экспериментальном режиме. В этих тестах они применили свою модель к коллаборативному роботу YuMi компании ABB.

Как в симуляциях, так и в экспериментах модель позволяла эффективно управлять движениями YuMi, позволяя лучше удерживать и манипулировать различными тканями, используя как одну руку, так и обе.

Наборы данных, собранные исследователями, и код их модели доступны на GitHub. В будущем эта работа может открыть путь к дальнейшему прогрессу в области робототехники. В частности, она может помочь расширить возможности мобильных роботов, предназначенных для помощи человеку в работе по дому, улучшив их способность справляться с различными тканями.

Комментарии

(0) Добавить комментарий