Вдохновившись способностью человека обращаться с незнакомыми предметами, группа специалистов из MIT CSAIL разработала систему Feature Fields for Robotic Manipulation (F3RM), которая объединяет 2D-изображения в 3D-сцены, помогая роботам распознавать и захватывать близлежащие предметы.

F3RM позволяет роботам интерпретировать текстовые подсказки на естественном языке, помогая им манипулировать предметами. В результате роботы могут понимать менее конкретные запросы человека и при этом выполнять поставленную задачу. Например, если пользователь попросит робота "поднять высокую кружку", то робот сможет найти и взять предмет, наиболее подходящий под это описание.

"Создать роботов, способных к обобщенным действиям в реальном мире, невероятно сложно, - говорит Гэ Янг, постдок в MIT CSAIL. - Мы очень хотим понять, как это сделать, поэтому в этом проекте мы пытаемся добиться агрессивного уровня обобщения - от трех или четырех объектов до всего, что мы найдем в MIT Stata Center. Мы хотели научиться делать роботов такими же гибкими, как мы сами, поскольку мы можем схватывать и размещать объекты, даже если никогда их раньше не видели".

Этот метод может помочь роботам при отборе товаров в крупных центрах обработки заказов, где неизбежно возникает беспорядок и непредсказуемость. На таких складах роботам часто дают описание товара, который они должны идентифицировать. Роботы должны сопоставить предоставленный текст с объектом, независимо от разницы в упаковке. Например, в центрах обработки заказов крупных интернет-магазинов могут храниться миллионы товаров, со многими из которых робот никогда раньше не сталкивался. Для работы в таких масштабах роботам необходимо понимать геометрию и семантику различных предметов, причем некоторые из них могут находиться в ограниченном пространстве. Благодаря расширенным возможностям пространственного и семантического восприятия F3RM робот сможет более эффективно находить предметы, помещать их в контейнер и отправлять на упаковку.

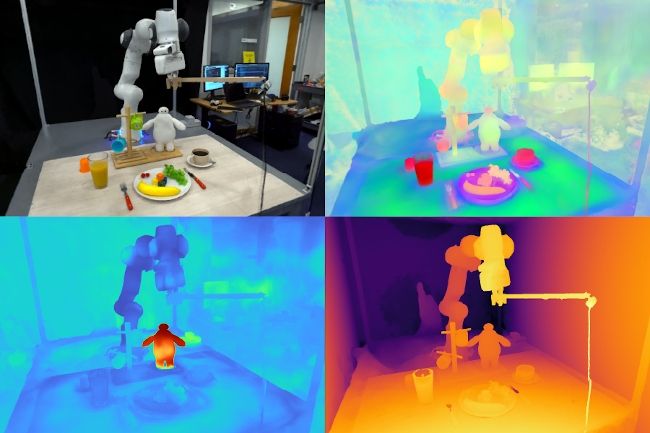

Система F3RM с помощью селфи-палки делает 50 снимков с различных ракурсов, что позволяет использовать Neural Radiance Fields (NeRF) - метод глубокого обучения, который использует 2D-изображения для построения 3D-сцены. Этот коллаж из RGB-фотографий создает "цифрового двойника" окружающей среды. Помимо этого F3RM строит поле признаков, дополняя геометрию семантической информацией. Система использует Contrastive Language-Image Pre-Training (CLIP) - это базовая модель, обученная на огромном наборе данных пар изображений и текста.

Чтобы продемонстрировать способность системы интерпретировать открытые запросы человека, исследователи попросили робота поднять Бэймакса, персонажа диснеевского фильма «Город героев». Хотя F3RM никогда не обучали подбирать игрушку, робот использовал свои пространственные знания и зрительно-языковые функции из базовых моделей, чтобы определить объект и способ его захвата.

Работа "Distilled Feature Fields Enable Few-Shot Language-Guided Manipulation" была выложена на сайте arXiv и будет представлена на Conference on Robot Learning 2023 на следующей неделе.

Комментарии

(0) Добавить комментарий