Одни из наиболее популярных видео на YouTube связаны с комическими неудачами роботов на финальном этапе конкурса DARPA Robotics Challenge (DRC) 2015, когда эти гуманоиды действовали в приближенных к аварийным условиях. Многие были удивлены, увидев, как роботы падают и опрокидываются, пытаясь выполнить такие простые действия, как открытие двери.

Но теперь исследователи из Массачусетского технологического института (MIT) разработали метод обучения, который способен сделать роботов более искусными в решении физических задач в чрезвычайных ситуациях. C-LEARN или «ограничивающее обучение» сочетает базу знаний с демонстрацией обучения, по существу, обеспечивая робота информацией, а затем указывая, как использовать ее.

Одним из аспектов является планирование движения, представляющее ряд шагов, которые робот должен предпринять, чтобы выполнить некоторое действие, как, например, переход к заданной точке. C-LEARN объединяет методики машинного обучения и планирования движения таким образом, чтобы не являющиеся робототехниками или программистами люди могли научить робота решению новых задач, затем новые навыки могут быть легко переданы другим роботам.

Этот подход объединяет два общих для робототехники метода программирования движения. Первый из них – это демонстрация, например, перемещение рукой манипулятора так, чтобы он смог захватить чашку. Второй метод связан с оптимизацией и пробами, в котором программист определяет цель действий и какие-либо ограничения.

Первый метод часто трудно распространить на другие ситуации, а второй может потребовать много времени и специальных знаний. Однако теперь, используя C-LEARN, можно просто научить робота новым действиям, предоставив базовую информацию о манипулировании объектами, а затем выполнив одну демонстрацию. Метод также позволяет машине приспосабливаться к новым ситуациям, например, если она сталкивается с препятствием при использовании изучаемой информации.

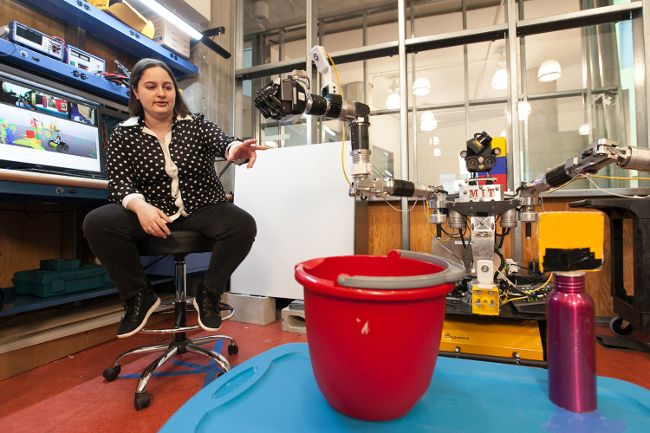

Исследователи проверили этот подход с роботом Optimus, имеющим два манипулятора. Опираясь на имеющуюся у него информацию, робот может автоматически сформулировать свои собственные планы передвижения, которые человек-оператор может редактировать.

«Этот подход на самом деле очень похож на процесс обучения людей. Сначала нужно увидеть некоторое действие, а затем соединить полученные данные с уже известными знаниями о мире», - говорит аспирант Клаудиа Перес-Д'Арпино. Робот лучше работал с человеком-оператором, который мог исправить небольшие ошибки, по сравнению с автономным поведением.

Исследователи также смогли передать приобретенные навыки Optimus двуногому гуманоидному роботу Atlas от Boston Dynamics, который ранее участвовал в DRC. Есть надежда, что C-LEARN позволит роботам более точно действовать в чрезвычайных ситуациях, где каждое движение в настоящее время управляется дистанционно, а также работать в производственных цехах и сервисных службах.

Комментарии

(0) Добавить комментарий