Группа исследователей под руководством доцента Лу Шицзяня из Nanyang Technological University (NTU) разработала компьютерную программу, которая создает реалистичные видеоролики, отражающие мимику и движения головы говорящего человека. Для этого требуется только аудиозапись и фото лица.

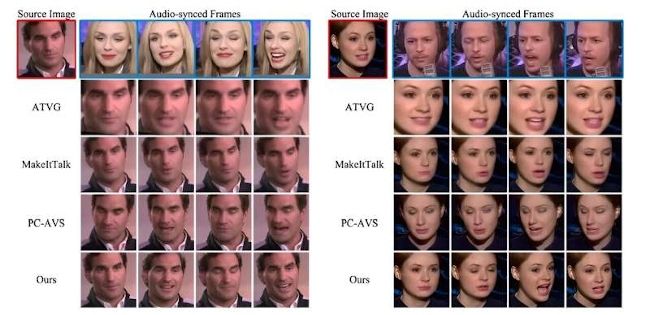

DIverse yet Realistic Facial Animations (DIRFA), - это ПО, основанное на ИИ, которое, получив аудиозапись и фотографию, создает 3D-видео на котором аватар демонстрирует реалистичные и последовательные лицевые анимации, синхронизированные с произносимым звуком. Сообщается, что программа превосходит существующие подходы, которые с трудом справляются с изменением позы и эмоциональным контролем. Для этого команда обучила DIRFA на более чем 1 млн. аудиовизуальных клипов с участием более 6 тыс. человек, взятых из открытой базы данных, чтобы предсказать сигналы из речи и связать их с мимикой и движениями головы.

Исследователи рассчитывают, что DIRFA сможет найти новые применения в различных отраслях и сферах, включая здравоохранение, поскольку она позволяет создавать более сложных и реалистичных виртуальных помощников. Кроме того, она может стать полезным инструментом для людей с нарушениями речи, помогая им передавать свои мысли и эмоции с помощью выразительных аватаров или цифровых представлений, повышая их способность к общению.

"Влияние нашего исследования может быть глубоким и далеко идущим, поскольку оно революционизирует сферу мультимедийных коммуникаций, позволяя создавать высокореалистичные видеоролики говорящих людей, сочетая такие методы, как ИИ и машинное обучение - говорит доцент Шицзянь. - Наша программа также опирается на предыдущие исследования и представляет собой прогресс в технологии, поскольку видеоролики, созданные с помощью нашей программы, дополнены точными движениями губ, яркой мимикой и естественными позами головы, при этом используются только их аудиозаписи и статичные изображения".

"Речь имеет множество вариаций. Люди произносят одни и те же слова по-разному в различных контекстах, варьируя продолжительность, амплитуду, тон и т.д. Кроме того, помимо лингвистического содержания, речь передает богатую информацию об эмоциональном состоянии говорящего и таких факторах его личности, как пол, возраст, этническая принадлежность и даже черты характера. - говорит доктор Ву Ронглианг, первый автор статьи. - Наш подход представляет собой новаторскую попытку повысить производительность с точки зрения обучения представлению звука в ИИ и машинном обучении".

Исследователи планируют добавить дополнительные опции и усовершенствовать интерфейс DIRFA, а также доработать мимику с помощью более широкого набора данных, включающего разнообразные выражения лица и голосовые аудиоклипы. Работа "Audio-driven talking face generation with diverse yet realistic facial animations" была опубликована в журнале Pattern Recognition.

Комментарии

(0) Добавить комментарий