В последнее время все больше внимания привлекают «дипфейки» (deepfakes) – фальшивые фотографии и видеоролики, измененные с помощью компьютерных алгоритмов. За счет специальных манипуляций удается создать впечатление, что определенные люди делают то, чего они никогда не делали в реальности.

Такие фальшивые видео могут в будущем стать серьезной проблемой, поэтому в Калифорнийском университете разработали новую экспериментальную нейросеть для распознавания дипфейков.

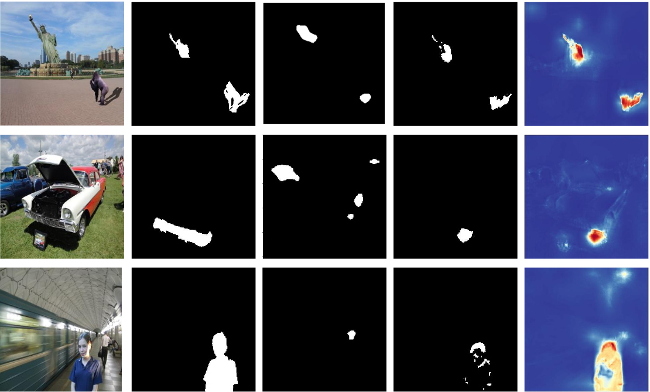

Нейросеть обучили на примере большой базы данных оригинальных и фальшивых изображений, помеченных соответствующим образом. На отредактированных фотографиях ученые выделили границы добавленных фрагментов – как правило, на фальшивых изображениях границы измененных предметов отличаются от оригинальных. Эти различия не всегда видны людям, однако тщательный компьютерный анализ позволит их распознать. С помощью подборки обучающих фотографий новая нейросеть выделила закономерности в предоставленных данных. В ходе последующих испытаний с незнакомыми изображениями система определила дипфейки «в большинстве случаев».

Пока нейросеть работает только с фотографиями, однако команда рассчитывает приспособить ее и к видеороликам – скорее всего, алгоритм будет анализировать отдельные кадры. Вероятно, что технология никогда не выйдет на уровень абсолютной точности и сможет только предварительно отмечать подозрительные изображения, которые затем будут просматривать люди.

Кликните для увеличения

Комментарии

(0) Добавить комментарий