Исследователи искусственного интеллекта из Facebook Inc., Принстонского университета и Массачусетского технологического института объединились, чтобы опубликовать новую работу, которая, по их словам, предлагает теоретическую основу, впервые описывающую, как на самом деле работают глубокие нейронные сети (deep neural networks, DNN).

В блоге исследователь из Facebook Шо Яида отметил, что DNN являются одним из ключевых ингредиентов современных исследований искусственного интеллекта. Но для многих людей, в том числе для большинства исследователей ИИ, они считаются слишком сложными для понимания их принципов работы.

Это проблема, потому что, хотя большой прогресс в области ИИ был достигнут путем экспериментов, проб и ошибок, это означает, что исследователи игнорируют многие ключевые особенности DNN, которые делают их невероятно полезными. По словам Яиды, если исследователи будут лучше осведомлены об этих ключевых особенностях, это, вероятно, приведет к значительному прогрессу и разработке гораздо более эффективных моделей искусственного интеллекта.

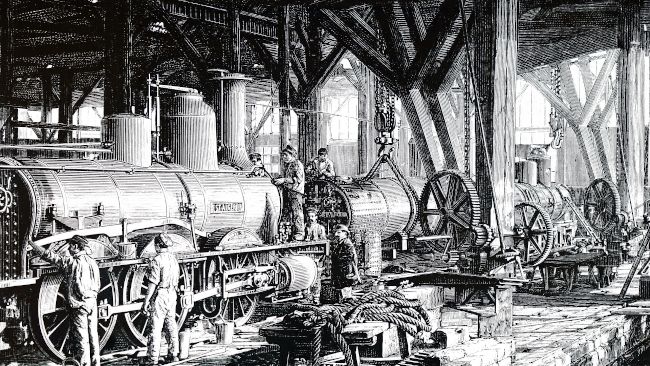

Яида сравнил ИИ сейчас и паровой двигатель в начале промышленной революции. Он сказал, что хотя паровая машина навсегда изменила производство, только в следующем столетии после изобретения ученые смогли полностью объяснить на теоретическом уровне, как она работает. Этот недостаток понимания не помешал усовершенствовать паровой двигатель, сказал он, но многие из внесенных улучшений были результатом проб и ошибок. После того, как ученые открыли принципы работы теплового двигателя, темпы улучшений значительно ускорились.

«Когда ученые наконец поняли статистическую механику, последствия вышли далеко за рамки создания более совершенных и эффективных двигателей, - писал Яида. - Статистическая механика привела к пониманию того, что материя состоит из атомов, предвосхитила развитие квантовой механики и (если смотреть целостным образом) даже привела к транзистору, который питает компьютер, который вы используете сегодня».

Yaida сказал, что ИИ в настоящее время находится в аналогичной ситуации, DNN рассматривается как черный ящик, который слишком сложен для понимания. В результате модели искусственного интеллекта настраиваются методом проб и ошибок, подобно тому, как люди улучшали паровой двигатель.

Конечно, по словам Яиды, метод проб и ошибок не обязательно плох, и это можно сделать разумно, опираясь на многолетний опыт. Но метод проб и ошибок - это лишь замена единого теоретического языка, описывающего DNN и то, как они на самом деле функционируют.

Работа под названием «The Principles of Deep Learning Theory: An Effective Theory Approach to Understanding Neural Networks» (PDF, 441 стр.) является попыткой восполнить этот пробел в знаниях.

«Для практиков искусственного интеллекта это понимание может значительно сократить количество проб и ошибок, необходимых для обучения DNN, - сказал Яида. - Например, он может выявить оптимальные гиперпараметры для любой данной модели, не прибегая к экспериментам, требующим больших затрат времени и вычислений».

Настоящая теория не для слабонервных и требует довольно сложного понимания физики. По словам Яиды, для большинства важными будут его разветвления, которые позволят теоретикам искусственного интеллекта стремиться к более глубокому и полному пониманию нейронных сетей.

«Еще многое предстоит вычислить, но эта работа потенциально приближает область к пониманию того, какие конкретные свойства этих моделей позволяют им работать разумно», - сказал он.

Принципы теории глубокого обучения доступны для загрузки сейчас на arXiv и будут опубликованы издательством Cambridge University Press в начале 2022 года.

Комментарии

(0) Добавить комментарий