Обучать роботов держать предметы – длительное и скучное занятие, именно поэтому ученые пытаются перевести их на самостоятельное машинное обучение с помощью искусственного интеллекта. Основная проблема такого обучения заключается в критериях успешности способа захвата объекта – робот считает, если объект удалось поднять и не уронить, этот захват можно считать успешным.

Тем не менее весьма вероятно, что этот способ не окажется оптимальным, а любые непредвиденные обстоятельства значительно повысят риск уронить предмет.

Для решения этой проблемы исследователи из Университета Карнеги-Меллон и Google решили объединить теорию игр и технологии глубинного обучения, чтобы повысить эффективность захвата предметов. Идея команды – ввести в процесс обучения противника, «злого робота», который разными способами пытается привести к падению предмета. Эта простая концепция заключается в усложнении условий задачи. Основные «противники» робота, которому необходимо взять предмет – гравитация, инерция и трение (или его отсутствие), но робот может и сам усложнить себе задачу, потряхивая объект во время поднятия.

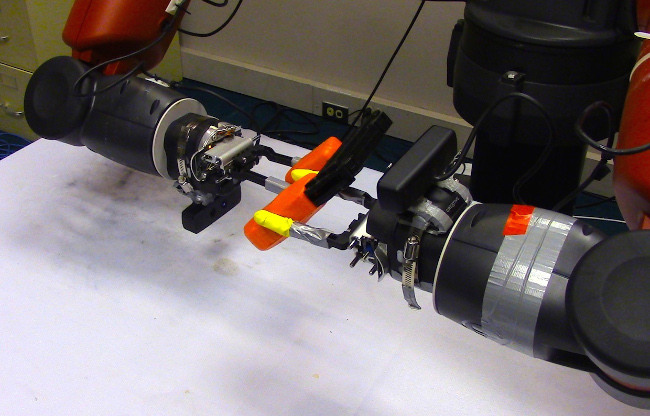

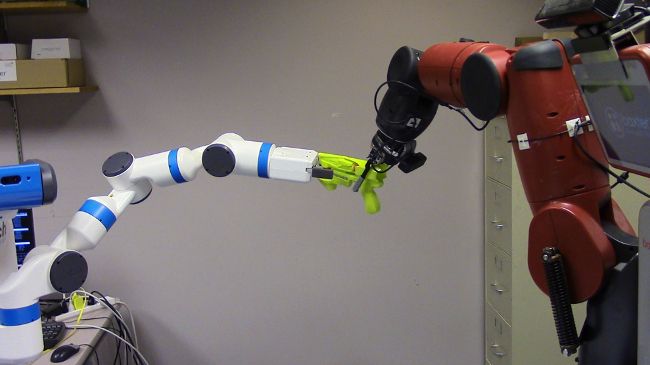

Преимущество роботов в том, что им можно запрограммировать «злое альтер-эго» для тряски объекта или соединить второй манипулятор, который будет постоянно мешать первому. Если противнику удастся победить, способ захвата будет признан неподходящим, и программа так и внесет его в базу данных. В свою очередь, программа противника запомнит свой успех – так, оба робота будут развиваться параллельно, все лучше выполняя соответствующие задачи.

Ученые показали, что такая стратегия может ускорить процесс обучения и повысить его качество. Они провели ряд испытаний, по результатам которых роботы, обучающиеся с противником, сумели успешно удержать новый предмет в 82% случаев – в ходе традиционного процесса обучения этот показатель составил 68%. В усложненных условиях с пониженной максимальной силой и трением успех новой стратегии составил 65%, а традиционного подхода – 47%. Это значительное улучшение, позволяющее говорить об эффективности метода, особенно для обучения большого количества роботов.

Основная цель в рамках нового подхода – настроить противника, который сделает задачу робота сложной, но все же возможной. Если в процесс включается тряска и выхватывание, робот вскоре учится выбирать более устойчивые способы захвата. В будущем ученые могут разработать и другие виды противников для более эффективного обучения.

Комментарии

(0) Добавить комментарий