Любовь японцев к роботам всем известна. Но является ли это чувство взаимным у удивительных андроидов из этой страны? Теперь мы можем приблизиться еще на шаг к тому, чтобы обеспечить роботам выразительную и более естественную мимику для общения.

В то время, как роботы представлены в здравоохранении, промышленности и в других сферах деятельности в Японии, трудно достижимой задачей для них остается человекоподобное выражение лица. Это связано с такими факторами, как огромный диапазон и асимметрия естественных движений лица человека, ограничения материалов, используемых для изготовления кожи роботов, и сложные инженерные и математические расчеты их движений.

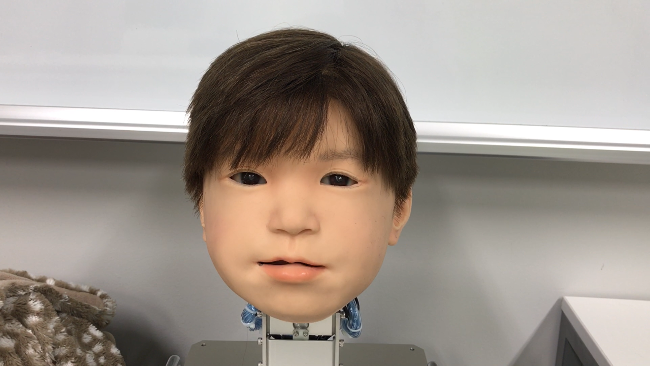

Недавно трое исследователей из Университета Осаки нашли метод для идентификации и количественной оценки движений лица, используя робота с головой ребенка. Модель первого поколения такого андроидного робота под названием Affetto была представлена еще в 2011 году. Исследователи создали системы второго поколения Affetto с более выразительным лицом. Полученные результаты предлагают возможность расширения диапазона выражаемых эмоций для андроидов и, в конечном счете, более глубокое взаимодействие с людьми.

«Поверхностные деформации являются ключевой проблемой в управлении лицами роботов, - объясняет проблему соавтор исследования Минору Асада. - Движения их мягкой кожи лица создают нестабильность, и это большая проблема, с которой мы сталкиваемся. Мы искали наилучший способ для измерения и контроля этих движений».

Исследователи изучили 116 различных точек лица на Affetto, чтобы измерить их трехмерное движение. «Полученные точные результаты позволят нам эффективно контролировать движения лица роботов, чтобы представить более детальные выражения, когда робот улыбается или хмурится»,- отмечают ученые.

Комментарии

(0) Добавить комментарий